Содержание

- Развертывание Open Single Management Platform

- Руководство по усилению защиты

- Схемы развертывания

- Порты, используемые Open Single Management Platform

- Подготовительные работы и развертывание

- Развертывание на нескольких узлах: подготовка устройства администратора и целевых устройств

- Развертывание на одном узле: подготовка устройства администратора и целевых устройств

- Подготовка устройств к установке сервисов KUMA

- Установка системы управления базами данных

- Настройка сервера PostgreSQL или Postgres Pro для работы с Open Single Management Platform

- Подготовка файла инвентаря KUMA

- Развертывание на нескольких узлах: параметры установки

- Развертывание на одном узле: параметры установки

- Указание параметров установки с помощью мастера настройки

- Установка Open Single Management Platform

- Настройка доступа в интернет целевых устройств

- Синхронизация времени на машинах

- Установка сервисов KUMA

- Развертывание нескольких кластеров Kubernetes и экземпляров Open Single Management Platform

- Предварительная проверка готовности инфраструктуры для развертывания

- Вход в Open Single Management Platform

- Обслуживание Open Single Management Platform

- Обновление Open Single Management Platform с версии 1.1 до версии 1.2

- Обновление компонентов Open Single Management Platform

- Добавление и удаление узлов кластера Kubernetes

- Контроль версий конфигурационного файла

- Удаление Open Single Management Platform

- Удаление компонентов Open Single Management Platform вручную

- Переустановка компонентов Open Single Management Platform

- Остановка узлов кластера Kubernetes

- Использование сертификатов для публичных служб Open Single Management Platform

- Расчет и изменение дискового пространства для хранения данных Сервера администрирования

- Ротация секретов

- Добавление устройств для установки дополнительных сервисов KUMA

- Замена устройства, использующего хранилище KUMA

- Настройка модели статусов инцидентов

Развертывание Open Single Management Platform

Следуя этому сценарию, вы можете подготовить инфраструктуру к развертыванию Open Single Management Platform и всех необходимых компонентов, подготовить конфигурационный файл, содержащий параметры установки, и развернуть решение с помощью утилиты Kaspersky Deployment Toolkit (далее также KDT).

Прежде чем приступить к развертыванию Open Single Management Platform и компонентов Open Single Management Platform, рекомендуется прочитать Руководство по усилению защиты.

Сценарий развертывания состоит из следующих этапов:

- Выбор варианта развертывания Open Single Management Platform

Выберите конфигурацию Open Single Management Platform, наиболее подходящую для вашей организации. Доступно развертывание на нескольких узлах и на одном узле:

- Загрузка дистрибутива с компонентами Open Single Management Platform

В состав дистрибутива входят следующие компоненты:

- Транспортный архив, который содержит компоненты Open Single Management Platform и Лицензионные соглашения Open Single Management Platform и KDT.

- Архив с утилитой KDT, а также шаблоны конфигурационного файла и файл инвентаря KUMA.

- Установка системы управления базами данных (СУБД)

Для развертывания на нескольких узлах вручную установите СУБД на отдельном сервере за пределами кластера Kubernetes.

Для развертывания на одном узле вручную установите СУБД на целевом устройстве перед развертыванием Open Single Management Platform. В этом случае компоненты СУБД и Open Single Management Platform устанавливаются на одном и том же целевом устройстве, но СУБД не будет включена в кластер Kubernetes.

Если вы выполняете демонстрационное развертывание и хотите установить СУБД внутри кластера, пропустите этот шаг. KDT установит СУБД во время развертывания Open Single Management Platform.

- Подготовка устройства администратора и целевых устройств

С учетом выбранной схемы развертывания определите количество целевых устройств, на которых вы будете разворачивать кластер Kubernetes и компоненты Open Single Management Platform, входящие в этот кластер. Подготовьте выбранные устройства администратора и целевые машины к развертыванию Open Single Management Platform.

Инструкции:

- Подготовка устройств KUMA

Подготовьте целевые устройства KUMA для установки сервисов KUMA (коллекторы, корреляторы и хранилища).

Инструкции: Подготовка устройств к установке сервисов KUMA.

- Подготовка файла инвентаря KUMA для установки сервисов KUMA

Подготовьте файл инвентаря KUMA в формате YAML. Файл инвентаря KUMA содержит параметры для установки сервисов KUMA

Инструкции: Подготовка файла инвентаря KUMA.

- Подготовка конфигурационного файла

Подготовьте конфигурационный файл в формате YAML. Конфигурационный файл содержит список целевых устройств для развертывания и набор параметров для установки компонентов Open Single Management Platform.

Если вы разворачиваете Open Single Management Platform на отдельном узле, используйте конфигурационный файл, содержащий параметры установки, предназначенные для развертывания на одном узле.

Инструкции:

- Развертывание на нескольких узлах: параметры установки

- Развертывание на одном узле: параметры установки

Вы можете заполнить шаблон конфигурационного файла вручную либо вы можете использовать мастер настройки, чтобы указать параметры установки, необходимые для развертывания Open Single Management Platform, и сгенерировать конфигурационный файл.

Инструкции: Указание параметров установки с помощью мастера настройки.

- Развертывание Open Single Management Platform

Разверните Open Single Management Platform с помощью KDT. KDT автоматически разворачивает кластер Kubernetes, в котором установлены компоненты Open Single Management Platform и другие компоненты инфраструктуры.

Инструкции: Установка Open Single Management Platform.

- Установка сервисов KUMA

Установите сервисы KUMA (коллекторы, корреляторы и хранилища) на подготовленные целевые устройства KUMA, расположенные вне кластера Kubernetes.

Инструкции: Установка сервисов KUMA.

- Настройка интеграции с Kaspersky Anti Targeted Attack Platform

Установите Central Node, чтобы получать телеметрию от Kaspersky Anti Targeted Attack Platform, а затем настройте интеграцию Open Single Management Platform и KATA/KEDR для управления действиями по реагированию на угрозы на активах, подключенных к серверам Kaspersky Endpoint Detection and Response.

При необходимости вы можете установить несколько компонентов Central Node, чтобы использовать их независимо друг от друга или объединить для централизованного управления в режиме распределенного решения. Чтобы объединить несколько компонентов Central Node, вам нужно организовать серверы с компонентами в иерархию.

При настройке серверов Central Node вам нужно указать минимально возможное значение в поле Хранилище, чтобы избежать дублирования данных между базами Open Single Management Platform и KEDR.

Руководство по усилению защиты

Приложение Open Single Management Platform предназначено для централизованного решения основных задач по управлению и обслуживанию системы защиты сети организации. Приложение предоставляет администратору доступ к детальной информации об уровне безопасности сети организации. Open Single Management Platform позволяет настраивать все компоненты защиты, построенной на основе приложений "Лаборатории Касперского".

Сервер администрирования имеет полный доступ к управлению защитой клиентских устройств и является важнейшим компонентом системы защиты организации. Поэтому для Сервера администрирования требуются усиленные меры защиты.

В Руководстве по усилению защиты описаны рекомендации и особенности настройки Open Single Management Platform и его компонентов для снижения рисков его компрометации.

Руководство по усилению защиты содержит следующую информацию:

- выбор схемы развертывания Сервера Администрирования;

- настройка безопасного подключения к Серверу Администрирования;

- настройка учетных записей для работы с Сервером администрирования;

- управление защитой Сервера администрирования;

- управление защитой клиентских устройств;

- настройка защиты управляемых приложений;

- обслуживание Сервера администрирования;

- передача информации в сторонние системы;

- рекомендации по безопасности сторонних информационных систем.

Управление инфраструктурой Open Single Management Platform

В этой статье описан общий принцип использования минимально необходимого количества приложений для работы операционной системы и Open Single Management Platform. Также в этой статье описан принцип минимальных привилегий, который сводится к концепции нулевого доверия.

Управление учетными записями операционной системы

Для работы с кластером Kubernetes с помощью KDT рекомендуется создать отдельного пользователя с минимальными правами. Оптимальным способом является реализация управления учетными записями пользователей операционной системы с помощью LDAP с возможностью отзыва прав пользователей через LDAP. Информацию о конкретной реализации отзыва прав и блокировки пользователей см. в руководстве пользователя/администратора в вашем решении LDAP. Рекомендуется использовать пароль длиной не менее 18 символов или парольную фразу, содержащую не менее 4 слов с любыми разделителями, для аутентификации пользователя. Также можно использовать физические средства аутентификации (например, токен).

Также рекомендуется защищать корневую директорию документов пользователя и все вложенные директории таким образом, чтобы только пользователь имел к ним доступ. Другие пользователи и группа пользователей не должны иметь прав на корневую директорию документов.

Рекомендуется не предоставлять права на запуск для директорий .ssh, .kube, .config и .kdt, а также для всех файлов, содержащихся в этих директориях в корневой директории документов пользователя.

Управление пакетами операционной системы

Рекомендуется использовать минимальный набор приложений, необходимый для работы KDT и Open Single Management Platform. Например, вам не нужно использовать графический пользовательский интерфейс для работы в кластере Kubernetes, поэтому не рекомендуется устанавливать графические пакеты. Если пакеты установлены, рекомендуется удалить эти пакеты, включая графические серверы, такие как Xorg или Wayland.

Рекомендуется регулярно устанавливать обновления безопасности для системного программного обеспечения и ядра Linux. Также рекомендуется включить автоматическое обновление следующим образом:

- Для операционных систем с диспетчером пакетов atp:

/etc/apt/apt.conf.d/50unattended-upgrades

Unattended-Upgrade::Allowed-Origins { "${distro_id}:${distro_codename}-security"; "${distro_id}ESMApps:${distro_codename}-apps-security"; "${distro_id}ESM:${distro_codename}-infra-security"; }; - Для операционных систем с диспетчером пакетов rp, dnf и yum:

/etc/dnf/automatic.conf

[commands] # Какое обновление выполнить: # default = все доступные обновления # security = только обновления безопасности upgrade_type = default # Следует ли скачивать обновления, когда они будут доступны, # dnf-automatic.timer. notifyonly.timer, download.timer и # install.timer отменяют этот параметр. download_updates = yes # Следует ли применять обновления, когда они будут доступны, # dnf-automatic.timer. notifyonly.timer, download.timer и # install.timer отменяют этот параметр. apply_updates = no

Параметры безопасности операционной системы

Параметры безопасности ядра Linux можно включить в файле /etc/sysctl.conf или с помощью команды sysctl. Рекомендуемые параметры безопасности ядра Linux перечислены во фрагменте файла /etc/sysctl.conf:

/etc/sysctl.conf

Рекомендуется ограничить доступ к PID. Это уменьшит вероятность того, что один пользователь будет отслеживать процессы другого пользователя. Вы можете ограничить доступ к PID при монтировании файловой системы /proc, например, добавив следующую строку в файл /etc/fstab:

Если процессы операционной системы управляются с помощью системы systemd, служба systemd-logind по-прежнему может контролировать процессы других пользователей. Для корректной работы пользовательских сессий в системе systemd необходимо создать файл /etc/systemd/system/systemd-logind.service.d/hidepid.conf и добавить в него следующие строки:

Так как в некоторых системах может не быть группы proc, рекомендуется добавить группу proc заранее.

С помощью команды systemctl mask ctrl-alt-del.target рекомендуется выключить комбинацию клавиш Ctrl+Alt+Del, чтобы предотвратить неожиданную перезагрузку операционной системы.

Рекомендуется запретить аутентификацию привилегированных пользователей (пользователей root) для установки удаленного подключения пользователя.

Рекомендуется использовать сетевой экран для ограничения сетевой активности. Об используемых портах и протоколах см. в разделе Порты, используемые Open Single Management Platform.

Рекомендуется включить auditd, чтобы упростить расследование инцидентов безопасности. О включении перенаправления телеметрии см. в разделе Настройка получения событий Auditd.

Рекомендуется регулярно создавать резервные копии следующих конфигураций и директорий данных:

- Устройство администратора:

~/kdt - Целевое устройство:

/etc/k0s/,/var/lib/k0s

Также рекомендуется зашифровать эти резервные копии.

Руководства по усилению защиты для различных операционных систем и СУБД

Если вам нужно настроить параметры безопасности вашей операционной системы и программного обеспечения, вы можете использовать рекомендации, предоставленные Center for Internet Security (CIS).

Если вы используете операционную систему Astra Linux, обратитесь к рекомендациям по безопасности, которые можно применить к вашей версии Astra Linux.

Если вам необходимо настроить параметры безопасности PostgreSQL, воспользуйтесь рекомендациями по администрированию сервера из официальной документации PostgreSQL.

В началоБезопасность соединения

Строгие параметры TLS

Рекомендуется использовать протокол TLS версии 1.2 или выше и ограничить или запретить использование небезопасных алгоритмов шифрования.

Вы можете настроить протоколы шифрования (TLS), используемые Сервером администрирования. При этом учитывайте, что на момент выпуска определенной версии Open Single Management Platform параметры протокола шифрования по умолчанию настроены так, чтобы обеспечить безопасную передачу данных.

Ограничение доступа к базе данных Open Single Management Platform

Рекомендуется ограничить доступ к базе данных Open Single Management Platform. Например, разрешить доступ только с устройств, на которых установлен Open Single Management Platform. Это позволит снизить вероятность взлома базы данных Open Single Management Platform через известные уязвимости.

Вы можете настроить параметры в соответствии с руководством по эксплуатации используемой базы данных, а также предусмотреть закрытые порты на сетевых экранах.

В началоУчетные записи и авторизация

Использование двухэтапной проверки Open Single Management Platform

Open Single Management Platform обеспечивает двухэтапную проверку для пользователей на основе стандарта RFC 6238 (TOTP: Time-Based One-Time Password Algorithm).

Если для вашей учетной записи включена двухэтапная проверка, каждый раз при входе в Open Single Management Platform с помощью браузера вы вводите свое имя пользователя, пароль и дополнительный одноразовый код безопасности. Для того чтобы получить одноразовый код безопасности, вам нужно установить приложение для аутентификации на своем компьютере или мобильном устройстве.

Существуют как программные, так и аппаратные аутентификаторы (токены), поддерживающие стандарт RFC 6238. Например, к программным аутентификаторам относятся Google Authenticator, Microsoft Authenticator, FreeOTP.

Категорически не рекомендуется устанавливать приложение для аутентификации на том же устройстве, с которого выполняется подключение к Open Single Management Platform. Например, вы можете установить приложение для аутентификации на мобильном устройстве.

Использование двухфакторной аутентификации операционной системы

Рекомендуется использовать многофакторную аутентификацию (MFA) на устройствах с развернутым Open Single Management Platform с помощью токена, смарт-карты или другим способом (если это возможно).

Запрет на сохранение пароля администратора

При работе с Open Single Management Platform через браузер не рекомендуется сохранять пароль администратора в браузере на устройстве пользователя.

Авторизация внутреннего пользователя

По умолчанию пароль внутренней учетной записи пользователя Open Single Management Platform должен соответствовать следующим требованиям:

Длина пароля должна быть от 8 до 16 символов.

Пароль должен содержать символы как минимум трех групп из списка ниже:

верхний регистр (A–Z);

нижний регистр (a–z);

числа (0–9);

специальные символы (@ # $ % ^ & * - _ ! + = [ ] { } | : ' , . ? / \ ` ~ " ( ) ;).

Пароль не должен содержать пробелов, символов Юникода или комбинации "." и "@", когда "." расположена перед "@".

По умолчанию максимальное количество попыток ввода пароля равно 10. Вы можете изменить количество попыток ввода пароля.

Пользователь может вводить неверный пароль ограниченное количество раз. После этого учетная запись пользователя блокируется на час.

Ограничение назначения роли Главного администратора

Пользователю назначается роль Главного администратора в списке контроля доступа (ACL) Open Single Management Platform. Не рекомендуется назначать роль Главного администратора большому количеству пользователей.

Настройка прав доступа к функциям приложения

Рекомендуется использовать возможности гибкой настройки прав доступа пользователей и групп пользователей к разным функциям Open Single Management Platform.

Управление доступом на основе ролей позволяет создавать типовые роли пользователей с заранее настроенным набором прав и присваивать эти роли пользователям в зависимости от их служебных обязанностей.

Основные преимущества ролевой модели управления доступом:

- простота администрирования;

- иерархия ролей;

- принцип наименьшей привилегии;

- разделение обязанностей.

Вы можете воспользоваться встроенными ролями и присвоить их определенным сотрудникам на основе должностей либо создать полностью новые роли.

При настройке ролей требуется уделить особое внимание привилегиям, связанным с изменением состояния защиты устройства с Open Single Management Platform и удаленной установкой стороннего программного обеспечения:

- Управление группами администрирования.

- Операции с Сервером администрирования.

- Удаленная установка.

- Изменение параметров хранения событий и отправки уведомлений.

Эта привилегия позволяет настроить уведомления, которые запускают скрипт или исполняемый модуль на устройстве с OSMP при возникновении события.

Отдельная учетная запись для удаленной установки приложений

Помимо базового разграничения прав доступа, рекомендуется ограничить возможность удаленной установки приложений для всех учетных записей, кроме "Главного администратора" или иной специализированной учетной записи.

Рекомендуется использовать отдельную учетную запись для удаленной установки приложений. Вы можете назначить роль или разрешения отдельной учетной записи.

Регулярный аудит всех пользователей

Рекомендуется проводить регулярный аудит всех пользователей на устройстве, где развернуто приложение Open Single Management Platform. Это позволит реагировать на некоторые типы угроз безопасности, связанные с возможной компрометацией устройства.

В началоУправление защитой Open Single Management Platform

Выбор программного обеспечения защиты Open Single Management Platform

В зависимости от типа развертывания Open Single Management Platform и общей стратегии защиты выберите приложение для защиты устройств с развернутым Open Single Management Platform и устройства администратора.

Если вы разворачиваете Open Single Management Platform на выделенных устройствах, рекомендуется выбрать приложение Kaspersky Endpoint Security для защиты устройств с развернутым Open Single Management Platform и устройства администратора. Это позволит применить все имеющиеся технологии для защиты этих устройств, в том числе модули поведенческого анализа.

Если Open Single Management Platform разворачивается на устройствах, которые уже существуют в инфраструктуре и ранее использовались для выполнения других задач, рекомендуются следующие приложения защиты:

- Kaspersky Industrial CyberSecurity for Nodes. Это приложение рекомендуется устанавливать на устройства, входящие в промышленную сеть. Kaspersky Industrial CyberSecurity for Nodes – это приложение, имеющее сертификаты совместимости с различными производителями промышленного программного обеспечения.

- Рекомендованные приложения безопасности. Если Open Single Management Platform развернут на устройствах с другим программным обеспечением, нужно ознакомиться с рекомендациями производителя программного обеспечения по использованию антивирусных приложений (возможно, уже существуют рекомендации по выбору приложения защиты, и, вероятно, вам потребуется выполнить настройку доверенной зоны).

Модули защиты

Если отсутствуют особые рекомендации от производителя стороннего программного обеспечения, установленного на тех же устройствах, что и Open Single Management Platform, рекомендуется активировать и настроить все доступные модули защиты (после проверки их работы в течение определенного времени).

Настройка сетевого экрана устройств с Open Single Management Platform

На устройствах с развернутым Open Single Management Platform рекомендуется настроить сетевой экран, чтобы ограничить количество устройств, с которых администраторы могут подключаться к Open Single Management Platform через браузер.

По умолчанию

Open Single Management Platform использует порт 443 для входа в систему через браузер. Рекомендуется ограничить число устройств, с которых Open Single Management Platform может управляться по этим портам.

В началоУправление защитой клиентских устройств

Ограничение добавления лицензионных ключей в инсталляционные пакеты

Инсталляционные пакеты можно публиковать с помощью Веб-сервера, входящего в состав Open Single Management Platform. Если вы добавите лицензионный ключ в инсталляционный пакет, опубликованный на Веб-сервере, лицензионный ключ будет доступен для чтения всем пользователям.

Для того чтобы избежать компрометации лицензионного ключа, не рекомендуется добавлять лицензионные ключи в инсталляционные пакеты.

Рекомендуется использовать автоматическое распространение лицензионных ключей на управляемые устройства, выполнять развертывание с помощью задачи Добавление лицензионного ключа для управляемого приложения и добавлять код активации или файл ключа на устройства вручную.

Правила автоматического перемещения устройств между группами администрирования

Рекомендуется ограничить использование правил автоматического перемещения устройств между группами администрирования.

Использование правил автоматического перемещения может привести к тому, что на устройство будут распространены политики, предоставляющие более широкий набор привилегий, чем было до перемещения.

Перемещение клиентского устройства в другую группу администрирования может привести к распространению на него параметров политик. Эти параметры политик могут быть нежелательны к распространению на гостевые и недоверенные устройства.

Эта рекомендация, не относится к первоначальному распределению устройств по группам администрирования.

Требования к безопасности к устройствам с точками распространения и шлюзам соединений

Устройства с установленным Агентом администрирования могут использоваться в качестве точки распространения и выполнять следующие функции:

- Распространять обновления и инсталляционные пакеты, полученные от Open Single Management Platform, на клиентские устройства в группе.

- Выполнять удаленную установку приложений сторонних производителей и приложений "Лаборатории Касперского" на клиентские устройства.

- Опрашивать сеть с целью обнаружения новых устройств и обновления информации об уже известных устройствах. Точка распространения может использовать те же методы обнаружения устройств, что и Open Single Management Platform.

Размещение точек распространения в сети организации используется для следующих задач:

- снижение нагрузки на Open Single Management Platform;

- оптимизация трафика;

- предоставление Open Single Management Platform доступа к устройствам в труднодоступных частях сети.

С учетом доступных возможностей рекомендуется защитить, в том числе физически, устройства, выполняющие роль точек распространения, от любого типа несанкционированного доступа.

Ограничение автоматического назначения точек распространения

Для упрощения администрирования и сохранения работоспособности сети рекомендуется воспользоваться автоматическим назначением точек распространения. Однако в промышленных и небольших сетях рекомендуется избегать автоматического назначения точек распространения, так как на точки распространения могут быть, например, переданы конфиденциальные сведения учетных записей, используемых для работы задач принудительной удаленной установки средствами операционной системы.

В промышленных и небольших сетях вы можете назначить точки распространения вручную.

При необходимости вы также можете просмотреть Отчет о работе точек распространения.

В началоНастройка защиты управляемых приложений

Политики управляемых приложений

Рекомендуется создать политику для каждого вида используемого приложения и всех компонентов Open Single Management Platform (Агент администрирования, Kaspersky Endpoint Security для Windows, Kaspersky Endpoint Agent и другие). Эта групповая политика должна применяться ко всем управляемым устройствам (корневой группе администрирования) или к отдельной группе, в которую автоматически попадают новые управляемые устройства в соответствии с настроенными правилами перемещения.

Установка пароля на выключение защиты и удаление приложения

Настоятельно рекомендуется включить защиту паролем, чтобы злоумышленники не смогли выключить или удалить приложения безопасности "Лаборатории Касперского". На платформах, где поддерживается защита паролем, вы можете установить пароль, например, для Kaspersky Endpoint Security, Агента администрирования и других приложений "Лаборатории Касперского". После включения защиты паролем рекомендуется заблокировать соответствующие параметры, закрыв их "замком".

Использование Kaspersky Security Network

Во всех политиках управляемых приложений и в свойствах Open Single Management Platform рекомендуется использовать Kaspersky Security Network (KSN) и принять актуальное Положение о KSN. При обновлении Open Single Management Platform вы также можете принять обновленное Положение о KSN. Если использование облачных служб запрещено законодательством или иными нормативными актами, вы можете не включать KSN.

Регулярная проверка управляемых устройств

Для всех групп устройств вам нужно создать задачу, периодически запускающую полную проверку устройств.

Обнаружение новых устройств

Рекомендуется должным образом настроить параметры обнаружения устройств: настроить интеграцию с контроллерами доменов и указать диапазоны IP-адресов для обнаружения новых устройств.

В целях безопасности вы можете использовать группу администрирования по умолчанию, в которую попадают все новые устройства, и применяемые к этой группе политики по умолчанию.

В началоПередача событий в сторонние системы

В этом разделе описаны особенности передачи проблем безопасности, обнаруженных на клиентских устройствах, в системы сторонних производителей.

Мониторинг и отчеты

Для своевременного реагирования на проблемы безопасности вы можете настроить функции мониторинга и параметры отчетов.

Экспорт событий в SIEM-системы

Для максимально быстрого выявления проблем безопасности до того, как будет нанесен существенный ущерб, рекомендуется использовать передачу событий в SIEM-систему.

Уведомление по электронной почте о событиях аудита

Для своевременного реагирования на возникновение нештатных ситуаций рекомендуется настроить отправку Сервером администрирования уведомлений о публикуемых им событиях аудита, критических событиях, событиях отказа функционирования и предупреждениях.

Поскольку события аудита являются внутрисистемными, они регистрируются редко и количество уведомлений о подобных событиях вполне приемлемо для почтовой рассылки.

В началоСхемы развертывания

Существует два варианта развертывания Open Single Management Platform: на нескольких узлах или на одном узле кластера Kubernetes. Прежде чем начать, рекомендуется ознакомиться с доступными схемами развертывания и выбрать ту, которая лучше всего соответствует требованиям вашей организации. Вы можете использовать руководство по масштабированию, в котором описаны требования к оборудованию и рекомендуемый вариант развертывания в зависимости от количества устройств в организации.

В зависимости от выбранного варианта развертывания вам могут потребоваться следующие устройства для работы Open Single Management Platform:

- Устройство администратора

- Целевые устройства

- Устройство СУБД (только для развертывания на нескольких узлах)

- Устройство KATA/KEDR (необязательно)

Развертывание на нескольких узлах.

При развертывании на нескольких узлах компоненты Open Single Management Platform устанавливаются на нескольких рабочих узлах кластера Kubernetes, и при выходе из строя одного узла кластер может восстановить работу компонентов на другом узле.

В этой конфигурации вам понадобится минимум семь устройств:

- 1 устройство администратора;

- 4 целевых устройства для установки кластера Kubernetes и компонентов Open Single Management Platform;

- 1 устройство для установки СУБД;

- 1 целевое устройство KUMA для установки сервисов KUMA.

Развертывание на одном узле

При развертывании на одном узле все компоненты Open Single Management Platform устанавливаются на одном узле кластера Kubernetes. Вы можете выполнить развертывание Open Single Management Platform на одном узле, чтобы решение требовало меньше вычислительных ресурсов.

В этой конфигурации вам понадобится минимум три устройства:

- 1 устройство администратора;

- 1 целевое устройство для установки кластера Kubernetes, компонентов Open Single Management Platform и СУБД;

- 1 целевое устройство KUMA для установки сервисов KUMA.

В этой конфигурации СУБД не требует отдельного узла, но она должна быть установлена вручную на целевом устройстве перед развертыванием Open Single Management Platform.

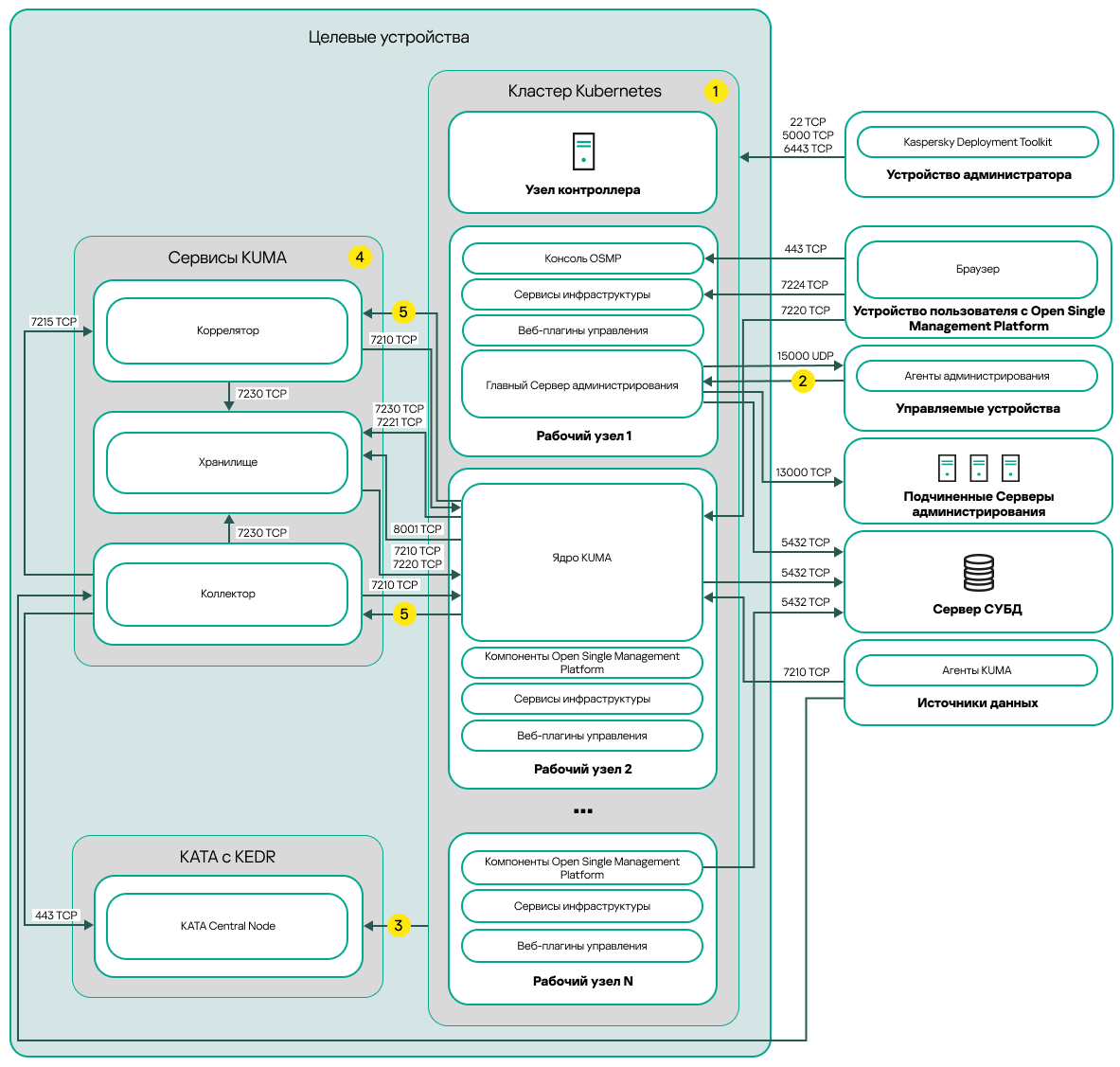

В началоСхема развертывания на нескольких узлах

На рисунке ниже приведена схема развертывания приложения Open Single Management Platform на нескольких узлах.

Схема развертывания Open Single Management Platform на нескольких узлах

Схема развертывания Open Single Management Platform на нескольких узлах включает следующие основные компоненты:

- Устройство администратора. На этом устройстве администратор использует Kaspersky Deployment Toolkit для развертывания и управления кластером Kubernetes и Open Single Management Platform. Устройство администратора не входит в кластер Kubernetes.

- Кластер Kubernetes. Кластер Kubernetes включает узел контроллера (также называемый первичным узлом во время процедуры развертывания) и как минимум три рабочих узла. Количество рабочих узлов может быть разным. На схеме распределение компонентов Open Single Management Platform по рабочим узлам показано в качестве примера. Фактическое распределение компонентов может отличаться.

- Сервер СУБД. Для корректной работы компонентов Open Single Management Platform необходим сервер с установленной системой управления базами данных. Администратор устанавливает СУБД вручную на отдельные серверы вне кластера Kubernetes.

- Устройства с сервисами KUMA. Сервисы KUMA (коллекторы, корреляторы и хранилища) устанавливаются на устройства, расположенные вне кластера Kubernetes. Количество целевых устройств для сервисов KUMA может отличаться.

- KATA с KEDR. Kaspersky Anti Targeted Attack Platform с функциональным блоком Kaspersky Endpoint Detection and Response. Подробную информацию о сценариях развертывания KATA см. в документации KATA.

- Устройство пользователя с Open Single Management Platform. Пользовательское устройство, которое используется для входа в Консоль OSMP или Консоль KUMA.

- Подчиненные Серверы администрирования (необязательно). Подчиненные Серверы администрирования используются для создания иерархии Серверов.

- Управляемые устройства. Клиентские устройства защищены Open Single Management Platform. На каждом управляемом устройстве установлен Агент администрирования.

Порты

На схеме не отображены все порты, необходимые для успешного развертывания. Полный список портов приведен в разделе Порты, используемые Open Single Management Platform.

Условные обозначения схемы:

![]() На схеме не показано взаимодействие внутри кластера Kubernetes между узлами и между компонентами Open Single Management Platform. Подробнее см. в разделе Порты, используемые Open Single Management Platform.

На схеме не показано взаимодействие внутри кластера Kubernetes между узлами и между компонентами Open Single Management Platform. Подробнее см. в разделе Порты, используемые Open Single Management Platform.

![]() Список портов, которые необходимо открыть на управляемых устройствах, приведен в разделе Порты, используемые Open Single Management Platform.

Список портов, которые необходимо открыть на управляемых устройствах, приведен в разделе Порты, используемые Open Single Management Platform.

![]() Подробнее об интеграции с KATA, включая функциональный блок KEDR, см. в разделе Интеграция с KATA/KEDR.

Подробнее об интеграции с KATA, включая функциональный блок KEDR, см. в разделе Интеграция с KATA/KEDR.

![]() На схеме сервисы KUMA развернуты по схеме развертывания на нескольких узлах. Количество целевых устройств для сервисов KUMA может отличаться. Список открываемых портов зависит от выбранной схемы развертывания. Полный список портов приведен в разделе Порты, используемые Open Single Management Platform.

На схеме сервисы KUMA развернуты по схеме развертывания на нескольких узлах. Количество целевых устройств для сервисов KUMA может отличаться. Список открываемых портов зависит от выбранной схемы развертывания. Полный список портов приведен в разделе Порты, используемые Open Single Management Platform.

![]() TCP-порт 7221 и другие порты для установки служб. Вы указываете эти порты как значение для --api.point <port>.

TCP-порт 7221 и другие порты для установки служб. Вы указываете эти порты как значение для --api.point <port>.

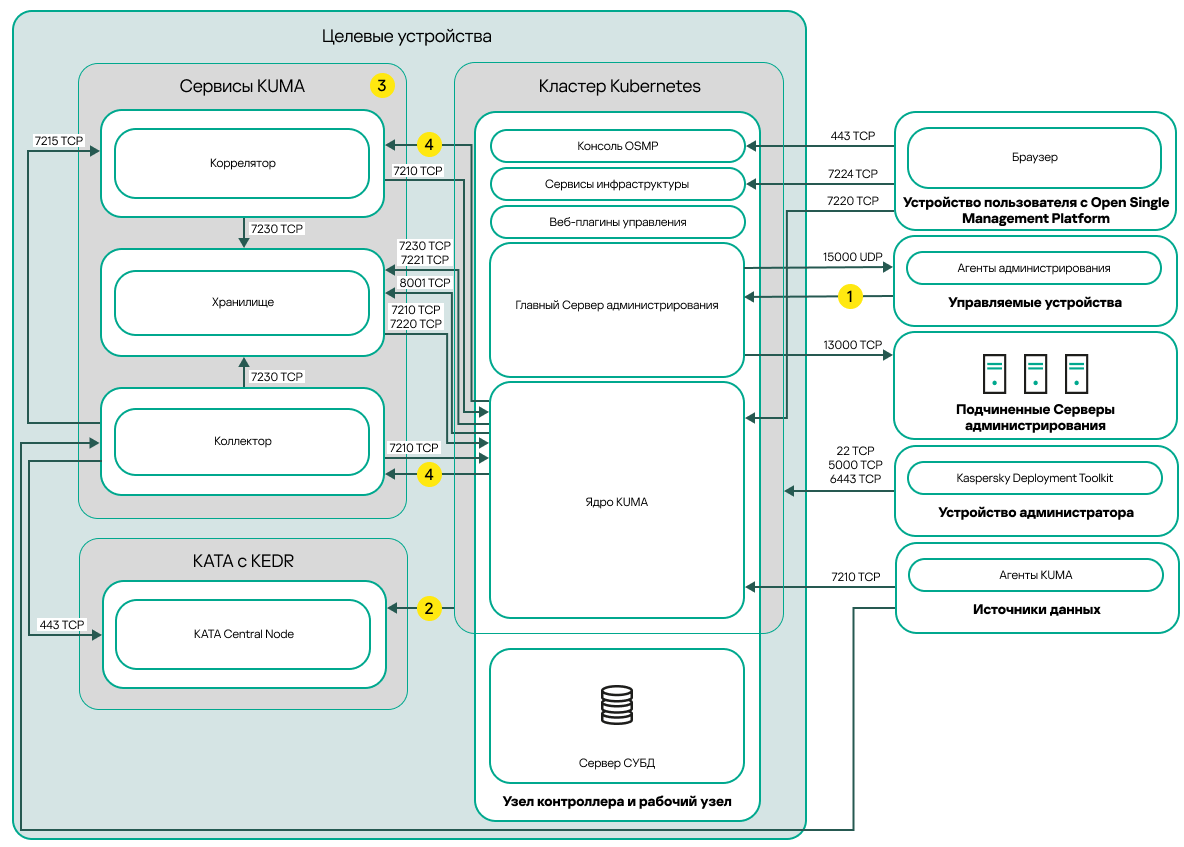

Схема развертывания на одном узле

На рисунке ниже приведена схема развертывания приложения Open Single Management Platform на одном узле.

Схема развертывания Open Single Management Platform на одном узле

Схема развертывания Open Single Management Platform на одном узле включает следующие основные компоненты:

- Устройство администратора. На этом устройстве администратор использует Kaspersky Deployment Toolkit для развертывания и управления кластером Kubernetes и Open Single Management Platform. Устройство администратора не входит в кластер Kubernetes.

- Кластер Kubernetes. Кластер Kubernetes включает в себя устройство, которое действует как узел контроллера (далее также первичный узел во время процедуры развертывания) и как рабочий узел.

- Сервер СУБД. Для корректной работы компонентов Open Single Management Platform необходим сервер с установленной системой управления базами данных. Сервер СУБД не входит в кластер Kubernetes. Администратор устанавливает СУБД вручную на целевом устройстве, которое будет действовать как первичный рабочий узел перед развертыванием Open Single Management Platform.

- Устройства с сервисами KUMA. Сервисы KUMA (коллекторы, корреляторы и хранилища) устанавливаются на устройства, расположенные вне кластера Kubernetes. Количество целевых устройств для сервисов KUMA может отличаться.

- KATA с KEDR. Kaspersky Anti Targeted Attack Platform с функциональным блоком Kaspersky Endpoint Detection and Response. Подробную информацию о сценариях развертывания KATA см. в документации KATA.

- Устройство пользователя с Open Single Management Platform. Пользовательское устройство, которое используется для входа в Консоль OSMP или Консоль KUMA.

- Подчиненные Серверы администрирования (необязательно). Подчиненные Серверы администрирования используются для создания иерархии Серверов.

- Управляемые устройства. Клиентские устройства защищены Open Single Management Platform. На каждом управляемом устройстве установлен Агент администрирования.

Порты

На схеме не отображены все порты, необходимые для успешного развертывания. Полный список портов приведен в разделе Порты, используемые Open Single Management Platform.

Условные обозначения схемы:

![]() Список портов, которые необходимо открыть на управляемых устройствах, приведен в разделе Порты, используемые Open Single Management Platform.

Список портов, которые необходимо открыть на управляемых устройствах, приведен в разделе Порты, используемые Open Single Management Platform.

![]() Подробнее об интеграции с KATA, включая функциональный блок KEDR, см. в разделе Интеграция с KATA/KEDR.

Подробнее об интеграции с KATA, включая функциональный блок KEDR, см. в разделе Интеграция с KATA/KEDR.

![]() На схеме сервисы KUMA развернуты по схеме развертывания на нескольких узлах. Количество целевых устройств для сервисов KUMA может отличаться. Список открываемых портов зависит от выбранной схемы развертывания. Полный список портов приведен в разделе Порты, используемые Open Single Management Platform.

На схеме сервисы KUMA развернуты по схеме развертывания на нескольких узлах. Количество целевых устройств для сервисов KUMA может отличаться. Список открываемых портов зависит от выбранной схемы развертывания. Полный список портов приведен в разделе Порты, используемые Open Single Management Platform.

![]() TCP-порт 7221 и другие порты для установки служб. Вы указываете эти порты как значение для --api.point <port>.

TCP-порт 7221 и другие порты для установки служб. Вы указываете эти порты как значение для --api.point <port>.

Порты, используемые Open Single Management Platform

Для правильного взаимодействия между устройством администратора и целевыми устройствами вам нужно предоставить доступ к соединению между устройством администратора и целевыми устройствами через порты, перечисленные в таблице ниже. Эти порты невозможно изменить.

Для взаимодействия между устройством администратора и устройствами, которые используются для установки сервисов KUMA и находятся вне кластера Kubernetes, доступ предоставляется только по TCP-порту 22.

Порты, используемые для взаимодействия между устройством администратора и целевыми устройствами

Порт |

Протокол |

Назначение порта |

|---|---|---|

22 |

TCP |

Обеспечение SSH-соединения от устройства администратора к целевым устройствам. Обеспечение SSH-соединения от устройства администратора к устройствам, которые используются для установки внешних сервисов KUMA. |

5000 |

TCP |

Подключение к реестру Docker. |

6443 |

TCP |

Подключение к Kubernetes API. |

Для корректной работы компонентов Open Single Management Platform целевые устройства должны находиться в одном широковещательном домене.

В таблице ниже указаны порты, которые должны быть открыты на сетевых экранах всех целевых устройств кластера. Эти порты невозможно изменить.

Если вы используете сетевой экран firewalld или UFW на целевых устройствах, KDT автоматически откроет требуемые порты на сетевых экранах. Или вы можете вручную открыть перечисленные порты перед развертыванием Open Single Management Platform.

Обязательные порты, используемые компонентами Open Single Management Platform

Порт |

Протокол |

Назначение порта |

|---|---|---|

80 |

TCP (HTTP) |

Прием соединений от браузера. Перенаправление на порт 443 TCP (HTTPS). |

443 |

TCP (HTTPS) |

Прием соединений от браузера. Прием соединений от Сервера администрирования по OpenAPI. Используется для автоматизации сценариев работы с Сервером администрирования. |

13000 |

TCP |

Прием соединений от Агентов администрирования и подчиненных Серверов администрирования. |

13000 |

UDP |

Прием информации от Агентов администрирования о выключении устройств. |

14000 |

TCP |

Прием подключений от Агентов администрирования. |

17000 |

TCP |

Прием подключений для активации приложений от управляемых устройств (кроме мобильных устройств). |

7210 |

TCP |

Получение конфигурации KUMA с сервера Ядра KUMA. |

7220 |

TCP |

Прием соединений от браузера. |

7222 |

TCP |

Реверсивный прокси в системе CyberTrace. |

7224 |

TCP |

Ответные вызовы для Identity and Access Manager (IAM). |

В таблице ниже указаны порты, которые по умолчанию не открываются на сетевых экранах при развертывании Open Single Management Platform. Эти порты невозможно изменить.

Если вам нужно выполнить действия, перечисленные в столбце Назначение порта в таблице ниже, вы можете открыть соответствующие порты на сетевых экранах всех целевых устройств вручную.

Необязательные порты на сетевом экране, используемые компонентами Open Single Management Platform

Порт |

Протокол |

Назначение порта |

|---|---|---|

8060 |

TCP |

Передача на клиентские устройства опубликованных инсталляционных пакетов. |

8061 |

TCP |

Передача на клиентские устройства опубликованных инсталляционных пакетов. |

13111 |

TCP |

Прием запросов от управляемых устройств к прокси-серверу KSN. |

15111 |

UDP |

Прием запросов от управляемых устройств к прокси-серверу KSN. |

17111 |

TCP |

Прием запросов от управляемых устройств к прокси-серверу KSN. |

5432 |

TCP |

Взаимодействие с СУБД (PostgreSQL). Этот порт используется только, если вы выполняете демонстрационное развертывание и устанавливаете СУБД на целевом устройстве внутри кластера Kubernetes. |

В таблице ниже указаны порты, которые необходимо открыть для работы кластера Kubernetes и компонентов инфраструктуры. Эти порты невозможно изменить.

Если вы используете сетевой экран firewalld или UFW на целевых устройствах, KDT автоматически откроет требуемые порты на сетевых экранах. Или вы можете вручную открыть перечисленные порты перед развертыванием Open Single Management Platform.

Порты, используемые кластером Kubernetes и компонентами инфраструктуры

Порт |

Протокол |

Узел |

|---|---|---|

80 |

TCP |

Первичный узел |

443 |

TCP |

Первичный узел |

10250 |

TCP |

Первичный узел |

9443 |

TCP |

Первичный узел |

6443 |

TCP |

Первичный узел |

8132 |

TCP |

Первичный узел |

5000 |

TCP |

Первичный узел |

80 |

TCP |

Рабочий узел |

443 |

TCP |

Рабочий узел |

179 |

TCP |

Рабочий узел |

10250 |

TCP |

Рабочий узел |

10255 |

TCP |

Рабочий узел |

9443 |

TCP |

Рабочий узел |

6443 |

TCP |

Рабочий узел |

9500 |

TCP |

Рабочий узел |

9501 |

TCP |

Рабочий узел |

9502 |

TCP |

Рабочий узел |

9503 |

TCP |

Рабочий узел |

8500 |

TCP |

Рабочий узел |

8501 |

TCP |

Рабочий узел |

3260 |

TCP |

Рабочий узел |

8000 |

TCP |

Рабочий узел |

8002 |

TCP |

Рабочий узел |

2049 |

TCP |

Рабочий узел |

3370 |

TCP |

Рабочий узел |

179 |

UDP |

Рабочий узел |

51820 |

UDP |

Рабочий узел |

51821 |

UDP |

Рабочий узел |

Для корректной работы сервисов KUMA, не входящих в кластер Kubernetes, вам нужно открыть порты, указанные в таблице ниже. В таблице ниже показаны значения сетевых портов по умолчанию. Эти порты автоматически открываются во время установки KUMA.

Порты, используемые для взаимодействия с внешними сервисами KUMA

Порт |

Протокол |

Направление |

Назначение подключения |

|---|---|---|---|

8123 |

HTTPS |

От службы хранилища к узлу кластера ClickHouse. |

Запись и получение нормализованных событий в кластере ClickHouse. |

9009 |

HTTPS |

Между репликами кластера ClickHouse. |

Внутренняя связь между репликами кластера ClickHouse для передачи данных кластера. |

2181 |

TCP |

От узлов кластера ClickHouse к службе координации репликации ClickHouse keeper. |

Получение и запись метаданных репликации репликами серверов ClickHouse. |

2182 |

TCP |

От одного сервиса координации репликации ClickHouse keeper к другому. |

Внутренняя связь между службами координации репликации для достижения кворума. |

8001 |

TCP |

От Victoria Metrics к серверу ClickHouse. |

Получение метрик работы сервера ClickHouse. |

9000 |

TCP |

От клиента ClickHouse к узлу кластера ClickHouse. |

Запись и получение данных в кластере ClickHouse. |

Если вы создаете дополнительный сервис KUMA (коллектор, коррелятор или хранилище) на сервере, вам необходимо вручную открыть порт, соответствующий созданному сервису на сервере. Вы можете использовать порт TCP 7221 или другой порт, используемый для установки службы.

Если используются стандартные примеры служб, при развертывании Open Single Management Platform автоматически открываются следующие порты:

- 7230 TCP

- 7231 TCP

- 7232 TCP

- 7233 TCP

- 7234 TCP

- 7235 TCP

- 5140 TCP

- 5140 UDP

- 5141 TCP

- 5144 UDP

Подготовительные работы и развертывание

В этом разделе описано, как подготовить инфраструктуру к развертыванию Open Single Management Platform, настроить параметры установки, необходимые для развертывания на нескольких узлах или развертывания на одном узле, а также как использовать мастер настройки для создания конфигурационного файла.

Вы узнаете, как установить Open Single Management Platform по схеме развертывания на нескольких узлах и развертывания на одном узле. Также в этом разделе содержится информация о том, как развернуть несколько кластеров Kubernetes с экземплярами Open Single Management Platform и переключаться между ними с помощью KDT.

Развертывание на нескольких узлах: подготовка устройства администратора и целевых устройств

Подготовка к развертыванию на нескольких узлах включает настройку устройства администратора и целевых устройств. После подготовки устройств и указания конфигурационного файла вы сможете развернуть Open Single Management Platform на целевых устройствах с использованием KDT.

Подготовка устройства администратора

Предварительно вам нужно подготовить устройство, которое будет выполнять роль устройства администратора, с которого будет запускаться KDT. Это устройство может быть включено или не включено в кластер Kubernetes, созданный с помощью KDT во время развертывания. Если устройство администратора не включено в кластер, оно будет использоваться только для развертывания и управления кластером Kubernetes и Open Single Management Platform. Если устройство администратора включено в кластер, оно также будет действовать как целевое устройство, которое используется для работы компонентов Open Single Management Platform.

Чтобы подготовить устройство администратора:

- Убедитесь, что оборудование и программное обеспечение на устройстве администратора соответствуют требованиям для KDT.

- Выделите не менее 10 ГБ свободного места в директории временных файлов (/

tmp) для KDT. Если у вас недостаточно свободного места в этой директории, выполните следующую команду, чтобы указать путь к другой директории:export TMPDIR=<new_directory>/tmp - Установите пакет для Docker версии 23 или выше, а затем выполните действия после установки, чтобы настроить устройство администрирования для правильной работы с Docker.

Не устанавливайте неофициальные версии пакета Docker из хранилищ операционных систем.

- Для устройства администратора, которое будет включено в кластер, выполните дополнительные подготовительные шаги.

Подготовка целевых устройств

Целевые устройства – это физические или виртуальные машины, которые используются для развертывания Open Single Management Platform и которые включены в кластер Kubernetes. Компоненты Open Single Management Platform работают на этих устройствах.

Одно из целевых устройств может быть использовано в качестве устройства администратора. В этом случае вам необходимо подготовить это устройство в качестве устройства администратора, как описано в предыдущей процедуре, а затем выполнить подготовку для целевого устройства.

Минимальная конфигурация кластера для развертывания на нескольких узлах включает четыре узла:

- Один первичный узел.

Первичный узел предназначен для управления кластером, хранения метаданных и распределения рабочей нагрузки.

- Три рабочих узла.

Рабочие узлы предназначены для выполнения рабочей нагрузки компонентов Open Single Management Platform.

Для оптимального распределения нагрузки между узлами рекомендуется использовать узлы с примерно одинаковой производительностью.

Вы можете установить СУБД внутри кластера Kubernetes при выполнении демонстрационного развертывания Open Single Management Platform. В этом случае выделите дополнительный рабочий узел для установки СУБД. KDT установит СУБД во время развертывания Open Single Management Platform.

Для развертывания на нескольких узлах, рекомендуется установить СУБД на отдельный сервер вне кластера. После развертывания Open Single Management Platform замена СУБД, которая установлена внутри кластера, на СУБД, установленную на отдельном сервере, недоступна. Вам необходимо удалить все компоненты Open Single Management Platform и снова установить Open Single Management Platform. В этом случае данные будут потеряны.

Чтобы подготовить целевые устройства:

- Убедитесь, что оборудование и программное обеспечение на целевых устройствах соответствуют требованиям для развертывания на нескольких узлах и целевые устройства расположены в одном широковещательном домене.

Для правильной работы Open Single Management Platform версия ядра Linux должна быть 5.15.0.107 или выше на целевых устройствах с операционной системой семейства Ubuntu.

Docker не должен быть установлен на целевых устройствах, кроме целевого устройства, которое будет использоваться в качестве устройства администратора. KDT установит все необходимое программное обеспечение и зависимости во время развертывания.

- На каждом целевом устройстве установите пакет sudo, если этот пакет еще не установлен. Для операционных систем семейства Debian установите пакет UFW на целевые устройства.

- На каждом целевом устройстве настройте файл /etc/environment. Если инфраструктура вашей организации использует прокси-сервер для доступа в интернет, подключите целевые устройства к интернету.

- На первичном узле с конфигурацией UFW разрешите IP-переадресацию. В файле

/etc/default/ufwустановите для параметраDEFAULT_FORWARD_POLICYзначениеACCEPT. - Предоставьте доступ к хранилищу пакетов. Это хранилище содержит следующие пакеты, необходимые для работы Open Single Management Platform:

- nfs-common

- tar

- iscsi-package

- wireguard

- wireguard-tools

KDT попытается установить эти пакеты во время развертывания из хранилища пакетов. Также эти пакеты можно установить вручную.

- Для первичного узла убедитесь, что установлен пакет curl.

- Для рабочих узлов убедитесь, что установлен пакет libnfs версии 12 и выше.

Пакеты curl и libnfs не устанавливаются во время развертывания из хранилища пакетов с помощью KDT. Вам нужно установить эти пакеты вручную, если они еще не установлены.

- Зарезервируйте статические IP-адреса для целевых устройств для шлюза кластера Kubernetes и для устройства с СУБД (если СУБД установлена внутри кластера).

Шлюз Kubernetes предназначен для подключения компонентов Open Single Management Platform, установленных внутри кластера Kubernetes. IP-адрес шлюза соединения указан в конфигурационном файле.

Для стандартного использования решения, когда вы устанавливаете СУБД на отдельный сервер, IP-адрес шлюза соединения – это IP-адрес в нотации CIDR, которая содержит маску подсети /32 (например, 192.168.0.0/32).

Для демонстрационных целей, когда вы устанавливаете СУБД внутри кластера Kubernetes, IP-адрес шлюза является IP-диапазоном (например, 192.168.0.1–192.168.0.2).

Убедитесь, что целевые устройства, шлюз соединения кластера Kubernetes и устройство с СУБД находятся в одном широковещательном домене.

- На своем DNS-сервере зарегистрируйте FQDN служб для подключения к службам Open Single Management Platform.

По умолчанию службы Open Single Management Platform доступны по следующим адресам:

- <console_host>.<smp_domain> – доступ к интерфейсу Консоли OSMP.

- <admsrv_host>.<smp_domain> – взаимодействие с Сервером администрирования.

- <kuma_host>.<smp_domain> – доступ к интерфейсу Консоли KUMA.

- <api_host>.<smp_domain> – доступ к API Open Single Management Platform.

- <psql_host>.<smp_domain> – взаимодействие с СУБД (PostgreSQL).

Где <console_host>, <admsrv_host>, <kuma_host>, <api_host> и <psql_host> являются именами устройств сервисов, <smp_domain> является доменным именем сервиса. Эти параметры являются частями сервисов FQDN, которые вы можете указать в конфигурационном файле. Если вы не указываете пользовательские значения имен служб устройств, используются значения по умолчанию:

console_host– "console",admsrv_host– "admsrv",kuma_host– "kuma",api_host– "api",psql_host– "psql".Зарегистрируйте FQDN службы <psql_host>.<smp_domain>, если вы установили СУБД внутри кластера Kubernetes на узле СУБД и вам нужно подключиться к СУБД.

В зависимости от того, где вы хотите установить СУБД, перечисленные FQDN служб должны быть преобразованы в IP-адрес кластера Kubernetes следующим образом:

- СУБД на отдельном сервере (стандартное использование).

В этом случае IP-адрес шлюза соединения – это адрес служб Open Single Management Platform (без учета IP-адреса СУБД). Например, если указан IP-адрес шлюза соединения 192.168.0.0/32, FQDN службы должны быть разрешаться следующим образом:

- <console_host>.<smp_domain> – 192.168.0.0/32

- <admsrv_host>.<smp_domain> – 192.168.0.0/32

- <kuma_host>.<smp_domain> – 192.168.0.0/32

- <api_host>.<smp_domain> – 192.168.0.0/32

- СУБД внутри кластера Kubernetes (демонстрационное развертывание).

В этом случае IP-адрес шлюза соединения представляет собой IP-диапазон. Первый IP-адрес диапазона – это адрес служб Open Single Management Platform (без учета IP-адреса СУБД). Второй IP-адрес диапазона – IP-адрес СУБД. Например, если указан IP-диапазон шлюза соединения 192.168.0.1–192.168.0.2, FQDN служб должны быть разрешены следующим образом:

- <console_host>.<smp_domain> – 192.168.0.1

- <admsrv_host>.<smp_domain> – 192.168.0.1

- <kuma_host>.<smp_domain> – 192.168.0.1

- <api_host>.<smp_domain> – 192.168.0.1

- <psql_host>.<smp_domain> – 192.168.0.2

- На целевых устройствах создайте учетные записи, которые будут использоваться для развертывания Open Single Management Platform.

Эти учетные записи используются для SSH-соединения и должны иметь возможность повышать привилегии (sudo) без ввода пароля. Для этого добавьте созданные учетные записи пользователей в файл

/etc/sudoers. - Настройте SSH-соединение между устройством администратора и целевыми устройствами:

- На устройстве администратора сгенерируйте SSH-ключи с помощью утилиты ssh-keygen без парольной фразы.

- Скопируйте открытый ключ на каждое целевое устройство (например, в директории

/home/<имя_пользователя>/.ssh) с помощью утилиты ssh-copy-id.Если вы используете целевое устройство в качестве устройства администратора, вам нужно скопировать на него открытый ключ.

- Для корректной работы компонентов Open Single Management Platform обеспечьте сетевой доступ между целевыми устройствами и при необходимости откройте требуемые порты на сетевом экране устройства администратора и целевых устройств.

- Настройте синхронизацию времени по протоколу Network Time Protocol (NTP) на устройстве администратора и целевых устройствах.

- При необходимости подготовьте пользовательские сертификаты для работы с публичными службами Open Single Management Platform.

Вы можете использовать один промежуточный сертификат, выданный на основе корневого сертификата организации, или конечные сертификаты для каждой службы. Подготовленные пользовательские сертификаты будут использоваться вместо самоподписанных сертификатов.

Развертывание на одном узле: подготовка устройства администратора и целевых устройств

Подготовка к развертыванию на одном узле включает настройку устройства администратора и целевых устройств. В конфигурации с одним узлом кластер Kubernetes и компоненты Open Single Management Platform устанавливаются на одном целевом устройстве. После подготовки целевого устройства и указания конфигурационного файла, вы сможете развернуть Open Single Management Platform на целевом устройстве с использованием KDT.

Подготовка устройства администратора

Предварительно вам нужно подготовить устройство, которое будет выполнять роль устройства администратора, с которого будет запускаться KDT. Это устройство может быть включено или не включено в кластер Kubernetes, созданный с помощью KDT во время развертывания. Если устройство администратора не включено в кластер, оно будет использоваться только для развертывания и управления кластером Kubernetes и Open Single Management Platform. Если устройство администратора включено в кластер, оно также будет действовать как целевое устройство, которое используется для работы компонентов Open Single Management Platform. В этом случае будет использовано только одно устройство для развертывания и работы решения.

Чтобы подготовить устройство администратора:

- Убедитесь, что оборудование и программное обеспечение на устройстве администратора соответствуют требованиям для KDT.

- Выделите не менее 10 ГБ свободного места в директории временных файлов (/

tmp) для KDT. Если у вас недостаточно свободного места в этой директории, выполните следующую команду, чтобы указать путь к другой директории:export TMPDIR=<new_directory>/tmp - Установите пакет для Docker версии 23 или выше, а затем выполните действия после установки, чтобы настроить устройство администрирования для правильной работы с Docker.

Не устанавливайте неофициальные версии пакета Docker из хранилищ операционных систем.

- Для устройства администратора, которое будет включено в кластер, выполните дополнительные подготовительные шаги.

Подготовка целевого устройства

Целевое устройство – это физическая или виртуальная машина, которая используются для развертывания Open Single Management Platform и которая включена в кластер Kubernetes. Целевое устройство управляет кластером Kubernetes, хранит метаданные, а также на этом устройстве работают компоненты Open Single Management Platform. Минимальная конфигурация кластера для развертывания с одним узлом включает одно целевое устройство, которое действует как первичный и рабочий узлы. На этом первичном рабочем узле установлен кластер Kubernetes и компоненты Open Single Management Platform.

Для стандартного использования вам нужно установить СУБД вручную на целевом устройстве перед развертыванием. В этом случае СУБД будет установлена на целевом устройстве, но не будет включена в кластер Kubernetes. Для демонстрационных целей вы можете установить СУБД внутри кластера с помощью KDT во время развертывания.

Если вы хотите запустить развертывание Open Single Management Platform с целевого устройства, вам нужно подготовить это устройство в качестве устройства администратора, как описано в предыдущей процедуре, а затем выполнить подготовку для целевого устройства.

Чтобы подготовить целевое устройство:

- Убедитесь, что оборудование и программное обеспечение на целевом устройстве соответствуют требованиям для развертывания на одном узле.

Для правильной работы Open Single Management Platform версия ядра Linux должна быть 5.15.0.107 или выше на целевом устройстве с операционной системой семейства Ubuntu.

Не устанавливайте Docker на целевом устройстве, если целевое устройство не будет использоваться в качестве устройства администратора. KDT установит все необходимое программное обеспечение и зависимости во время развертывания.

- Установите пакет sudo, если этот пакет еще не установлен. Для операционных систем семейства Debian установите пакет UFW.

- Настройте файл /etc/environment. Если инфраструктура вашей организации использует прокси-сервер для доступа в интернет, подключите целевое устройство к интернету.

- На первичном рабочем узле с конфигурацией UFW разрешите IP-переадресацию. В файле

/etc/default/ufwустановите для параметраDEFAULT_FORWARD_POLICYзначениеACCEPT. - Предоставьте доступ к хранилищу пакетов. Это хранилище содержит следующие пакеты, необходимые для работы Open Single Management Platform:

- nfs-common

- tar

- iscsi-package

- wireguard

- wireguard-tools

KDT попытается установить эти пакеты во время развертывания из хранилища пакетов. Также эти пакеты можно установить вручную.

- Убедитесь, что пакеты curl и libnfs установлены на первичном рабочем узле.

Пакеты curl и libnfs не устанавливаются во время развертывания из хранилища пакетов с помощью KDT. Вам нужно установить эти пакеты вручную, если они еще не установлены. Используется пакет libnfs версии 12 и выше.

- Зарезервируйте статические IP-адреса для целевого устройства и шлюза кластера Kubernetes.

Шлюз Kubernetes предназначен для подключения компонентов Open Single Management Platform, установленных внутри кластера Kubernetes.

Для стандартного использования решения, когда вы устанавливаете СУБД на целевое устройство вне кластера, IP-адрес шлюза соединения – это IP-адрес в нотации CIDR, которая содержит маску подсети /32 (например, 192.168.0.0/32).

Для демонстрационных целей, когда вы устанавливаете СУБД внутри кластера Kubernetes, IP-адрес шлюза является IP-диапазоном (например, 192.168.0.1–192.168.0.2).

Убедитесь, что целевое устройство и шлюз соединения кластера Kubernetes находятся в одном широковещательном домене.

- На своем DNS-сервере зарегистрируйте FQDN служб для подключения к службам Open Single Management Platform.

По умолчанию службы Open Single Management Platform доступны по следующим адресам:

- <console_host>.<smp_domain> – доступ к интерфейсу Консоли OSMP.

- <admsrv_host>.<smp_domain> – взаимодействие с Сервером администрирования.

- <kuma_host>.<smp_domain> – доступ к интерфейсу Консоли KUMA.

- <api_host>.<smp_domain> – доступ к API Open Single Management Platform.

- <psql_host>.<smp_domain> – взаимодействие с СУБД (PostgreSQL).

Где <console_host>, <admsrv_host>, <kuma_host>, <api_host> и <psql_host> являются именами устройств сервисов, <smp_domain> является доменным именем сервиса. Эти параметры являются частями сервисов FQDN, которые вы можете указать в конфигурационном файле. Если вы не указываете пользовательские значения имен служб устройств, используются значения по умолчанию:

console_host– "console",admsrv_host– "admsrv",kuma_host– "kuma",api_host– "api",psql_host– "psql".Зарегистрируйте FQDN службы <psql_host>.<smp_domain>, если вы установили СУБД внутри кластера Kubernetes на узле СУБД и вам нужно подключиться к СУБД.

В зависимости от того, где вы хотите установить СУБД, перечисленные FQDN служб должны быть преобразованы в IP-адрес кластера Kubernetes следующим образом:

- СУБД на целевом устройстве вне кластера Kubernetes (стандартное использование)

В этом случае IP-адрес шлюза соединения – это адрес служб Open Single Management Platform (без учета IP-адреса СУБД). Например, если указан IP-адрес шлюза соединения 192.168.0.0/32, FQDN службы должны быть разрешаться следующим образом:

- <console_host>.<smp_domain> – 192.168.0.0/32

- <admsrv_host>.<smp_domain> – 192.168.0.0/32

- <kuma_host>.<smp_domain> – 192.168.0.0/32

- <api_host>.<smp_domain> – 192.168.0.0/32

- СУБД внутри кластера Kubernetes (демонстрационное развертывание).

В этом случае IP-адрес шлюза соединения представляет собой IP-диапазон. Первый IP-адрес диапазона – это адрес служб Open Single Management Platform (без учета IP-адреса СУБД). Второй IP-адрес диапазона – IP-адрес СУБД. Например, если указан IP-диапазон шлюза соединения 192.168.0.1–192.168.0.2, FQDN служб должны быть разрешены следующим образом:

- <console_host>.<smp_domain> – 192.168.0.1

- <admsrv_host>.<smp_domain> – 192.168.0.1

- <kuma_host>.<smp_domain> – 192.168.0.1

- <api_host>.<smp_domain> – 192.168.0.1

- <psql_host>.<smp_domain> – 192.168.0.2

- Создайте учетные записи, которые будут использоваться для развертывания Open Single Management Platform.

Эти учетные записи используются для SSH-соединения и должны иметь возможность повышать привилегии (sudo) без ввода пароля. Для этого добавьте созданные учетные записи пользователей в файл

/etc/sudoers. - Настройте SSH-соединение между устройством администратора и целевыми устройствами:

- На устройстве администратора сгенерируйте SSH-ключи с помощью утилиты ssh-keygen без парольной фразы.

- Скопируйте открытый ключ на целевое устройство (например, в директорию

/home/<имя_пользователя>/.ssh) с помощью утилиты ssh-copy-id.Если вы используете целевое устройство в качестве устройства администратора, вам нужно скопировать на него открытый ключ.

- Для корректной работы компонентов Open Single Management Platform откройте требуемые порты на сетевом экране устройства администратора и целевых устройств.

- Настройте синхронизацию времени по протоколу Network Time Protocol (NTP) на устройстве администратора и целевых устройствах.

- При необходимости подготовьте пользовательские сертификаты для работы с публичными службами Open Single Management Platform.

Вы можете использовать один промежуточный сертификат, выданный на основе корневого сертификата организации, или конечные сертификаты для каждой службы. Подготовленные пользовательские сертификаты будут использоваться вместо самоподписанных сертификатов.

Подготовка устройств к установке сервисов KUMA

Сервисы KUMA (коллекторы, корреляторы и хранилища) устанавливаются на целевые устройства KUMA, расположенные вне кластера Kubernetes.

Доступ к сервисам KUMA выполняется с использованием FQDN целевых устройств KUMA. Устройство администратора должно иметь доступ к целевым устройствам KUMA по своим FQDN.

Чтобы подготовить целевые устройства KUMA к установке сервисов KUMA:

- Убедитесь, что выполнены требования к оборудованию, программному обеспечению и установке.

- Укажите имена устройств.

Вам нужно указать FQDN, например: kuma1.example.com.

Не рекомендуется изменять имя устройства KUMA после установки. Это сделает невозможным проверку подлинности сертификатов и нарушит сетевое взаимодействие между компонентами приложения.

- Выполните следующие команды:

hostname -fhostnamectl statusСравните результат команды

hostname -fи значение поляStatic hostnameв выводе командыhostnamectl status. Эти значения должны совпадать с FQDN устройства. - Настройте SSH-соединение между устройством администратора и целевыми устройствами KUMA:

Используйте SSH-ключи, созданные для целевых устройств. Скопируйте открытый ключ на целевые устройства KUMA с помощью утилиты ssh-copy-id.

- Зарегистрируйте целевые устройства KUMA в зоне DNS вашей организации, чтобы разрешить преобразование имен устройств в IP-адреса.

- Убедитесь, что на всех целевых устройствах KUMA настроена синхронизация времени по протоколу Network Time Protocol (NTP).

Устройство готово к установке сервисов KUMA.

В началоУстановка системы управления базами данных

Open Single Management Platform поддерживает системы управления базами данных (СУБД) PostgreSQL или Postgres Pro. Полный список поддерживаемых СУБД см. в разделе Аппаратные и программные требования.

Для каждого из следующих компонентов Open Single Management Platform требуется база данных:

- Сервер администрирования

- Платформа автоматизации

- Incident Response Platform (IRP)

- Identity and Access Manager (IAM)

Каждый компонент должен использовать отдельную базу данных в одном экземпляре СУБД. Рекомендуется устанавливать экземпляр СУБД вне кластера Kubernetes.

Для установки СУБД KDT требует наличия привилегированной учетной записи СУБД с правами на создание баз данных и других учетных записей СУБД. KDT использует эту привилегированную учетную запись СУБД для создания баз данных и других учетных записей СУБД, необходимых для работы компонентов Open Single Management Platform.

Сведения о том, как установить выбранную СУБД, см. в документации к этой СУБД.

После установки СУБД необходимо настроить параметры сервера СУБД для оптимизации работы СУБД с Open Single Management Platform.

В началоНастройка сервера PostgreSQL или Postgres Pro для работы с Open Single Management Platform

Open Single Management Platform поддерживает системы управления базами данных (СУБД) PostgreSQL или Postgres Pro. Полный список поддерживаемых СУБД см. в разделе Аппаратные и программные требования. Вы можете настроить параметры сервера СУБД для оптимизации работы СУБД с Сервером администрирования.

Путь по умолчанию к конфигурационному файлу: /etc/postgresql/<ВЕРСИЯ>/main/postgresql.conf

Рекомендуемые параметры для работы СУБД PostgreSQL и Postgres Pro с Сервером администрирования:

shared_buffers =25% от объема оперативной памяти устройства, на котором установлена СУБД.Если оперативной памяти меньше 1 ГБ, то оставьте значение по умолчанию.

max_stack_depth =если СУБД установлена на устройстве Linux, то параметр рассчитывается по формуле: максимальный размер стека (выполните командуulimit -s, чтобы получить это значение в КБ) минус 1 МБ.Если СУБД установлена на устройстве Windows, оставьте значение по умолчанию 2 МБ.

temp_buffers =24MBwork_mem =16MBmax_connections =220Это минимально рекомендованное значение, вы можете указать большее.

max_parallel_workers_per_gather =0maintenance_work_mem =128MB

После обновления файла postgresql.conf примените конфигурацию или перезапустите службу. Дополнительную информацию см. в документации PostgreSQL.

Если вы используете кластерную СУБД Postgres, укажите параметр max_connections для всех серверов СУБД и в конфигурации кластера.

Если вы используете Postgres Pro 15.7 или Postgres Pro 15.7.1, выключите параметр enable_compound_index_stats:

enable_compound_index_stats = off

Подробную информацию о параметрах сервера PostgreSQL и Postgres Pro, а также о том, как указать эти параметры, см. в документации соответствующей СУБД.

Подготовка файла инвентаря KUMA

Файл инвентаря KUMA – это файл в формате YAML, который содержит параметры установки для развертывания сервисов KUMA, не включенных в кластер Kubernetes. Путь к файлу инвентаря KUMA включен в конфигурационный файл, который используется Kaspersky Deployment Toolkit для развертывания Open Single Management Platform.

Шаблоны файла инвентаря KUMA находятся в дистрибутиве. Если вы хотите установить сервисы KUMA (хранилище, коллектор и коррелятор) на одном устройстве, используйте файл single.inventory.yaml. Чтобы установить сервисы на нескольких устройствах в сетевой инфраструктуре, используйте файл distributed.inventory.yaml.

Рекомендуется создать резервную копию файла инвентаря KUMA, который вы использовали для установки сервисов KUMA. Вы можете использовать его для удаления KUMA.

Чтобы подготовить файл инвентаря KUMA,

откройте шаблон файла инвентаря KUMA, расположенный в дистрибутиве, и измените переменные в файле инвентаря.

Файл инвентаря KUMA содержит следующие блоки:

allblockБлок

allсодержит переменные, которые применяются ко всем устройствам, указанным в файле инвентаря. Переменные находятся в разделеvars.kumablockБлок

kumaсодержит переменные, которые применяются к устройствам, на которых будут установлены сервисы KUMA. Эти устройства перечислены в блокеkumaв разделеchildren. Переменные находятся в разделеvars.

В таблице ниже перечислены возможные переменные, их описания, возможные значения и блоки файла инвентаря KUMA, в которых могут быть расположены эти переменные.

Список возможных переменных в разделе vars

Переменная |

Описание |

Возможные значения |

Блок |

Переменные, расположенные в разделе |

|||

|

Метод, используемый для подключения к устройствам с сервисами KUMA. |

Чтобы обеспечить правильную установку сервисов KUMA, в блоке В блоке |

|

|

Имя пользователя, используемое для подключения к устройствам с сервисами KUMA и для установки внешних сервисов KUMA. |

Если пользователь root заблокирован на целевых устройствах, укажите имя пользователя, у которого есть право устанавливать SSH-соединения и повышать привилегии с помощью su или sudo. Чтобы обеспечить правильную установку сервисов KUMA, в блоке В блоке |

|

|

Переменная указывает на создание предопределенных сервисов во время установки. |

|

|

|

Переменная, указывает на необходимость повышения прав учетной записи пользователя, которая используется для установки компонентов KUMA. |

|

|

|

Метод, используемый для повышения привилегий учетной записи пользователя, которая используется для установки компонентов KUMA. |

|

|

Переменные, расположенные в |

|||

|

Группа устройств, на которых хранятся служебные файлы и утилиты KUMA. Устройство может быть включено в группу Во время развертывания Open Single Management Platform на устройствах, входящих в

|

Группа устройств содержит переменную |

|

|

Группа устройств коллекторов KUMA. Эта группа может содержать несколько устройств. |

Группа устройств коллекторов KUMA содержит переменную |

|

|

Группа устройств корреляторов KUMA. Эта группа может содержать несколько устройств. |

Группа устройств корреляторов KUMA содержит переменную |

|

|

Группа устройств хранилищ KUMA. Эта группа может содержать несколько устройств. |

Группа устройств хранилищ KUMA содержит переменную В этой группе также можно указать структуру хранилища, если вы устанавливаете примеры сервисов во время демонстрационного развертывания ( |

|

Развертывание на нескольких узлах: параметры установки

Конфигурационный файл – это файл в формате YAML, содержащий набор параметров установки компонентов Open Single Management Platform.

Параметры установки, указанные в таблицах ниже, необходимы для развертывания на нескольких узлах Open Single Management Platform. Чтобы развернуть Open Single Management Platform на отдельном узле, используйте конфигурационный файл, содержащий параметры установки, характерные для развертывания на одном узле.

Шаблон конфигурационного файла (multinode.smp_param.yaml.template) находится в дистрибутиве в архиве с утилитой KDT. Вы можете заполнить шаблон конфигурационного файла вручную либо вы можете использовать мастер настройки, чтобы указать параметры установки, необходимые для развертывания Open Single Management Platform, и сгенерировать конфигурационный файл.

Не все перечисленные ниже параметры включены в шаблон конфигурационного файла. Этот шаблон содержит только те параметры, которые должны быть указаны перед развертыванием Open Single Management Platform. Остальные параметры имеют значения по умолчанию и не включены в шаблон. Вы можете вручную добавить эти параметры в конфигурационный файл, чтобы перезаписать их значения.

Для корректной работы KDT с конфигурационным файлом добавьте пустую строку в конце файла.

Раздел nodes конфигурационного файла содержит параметры установки для каждого целевого устройства кластера Kubernetes. Эти параметры перечислены в таблице ниже.

Раздел nodes

Имя параметра |

Обязательный |

Описание |

|---|---|---|

|

Да |

Название узла. |

|

Да |

Возможные значения параметра:

|

|

Да |

IP-адрес узла. Все узлы должны быть включены в одну подсеть. |

|

Нет |

Тип узла, определяющий компонент Open Single Management Platform, который будет установлен на этом узле. Возможные значения параметра:

Для корректной работы Open Single Management Platform рекомендуется выбрать узлы, на которых будет работать Сервер администрирования и компонент для взаимодействия с НКЦКИ. Также вы можете выбрать узел, на который хотите установить СУБД. Укажите соответствующие значения параметра |

|

Да |

Имя пользователя учетной записи, созданной на целевом устройстве и используемой для подключения к узлу с помощью KDT. |

|

Да |

Путь к закрытой части SSH-ключа, который находится на устройстве администратора и используется для подключения к узлу KDT. |

Остальные параметры установки перечислены в разделе parameters конфигурационного файла и описаны в таблице ниже.

Раздел параметров

Имя параметра |

Обязательный |

Описание |

|---|---|---|

|

Да |

Строка подключения для доступа к СУБД, которая установлена и настроена на отдельном сервере. Укажите этот параметр следующим образом:

Значение параметра Символы, которые требуется заменить в значении параметра